Если в последние годы вы загружали в Интернет какие-либо фотографии, скорее всего, они использовались для создания систем распознавания лиц. Разработчики обычно тренируют алгоритмы распознавания лиц на изображениях с веб-сайтов без ведома тех, кто их разместил. И это жутковато.

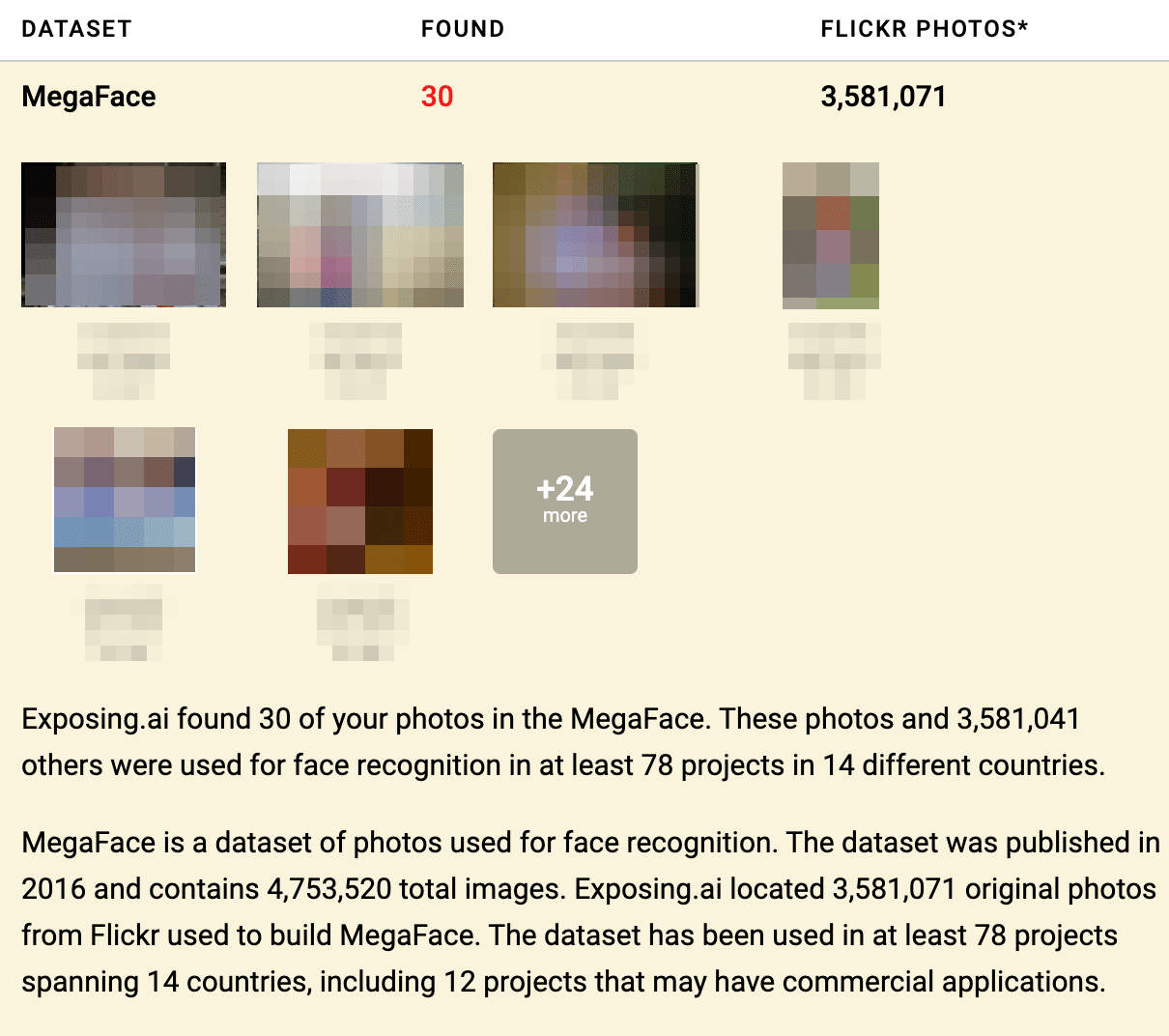

Новый онлайн-инструмент Exposing.AI поможет вам узнать, есть ли ваши фотографии среди снимков, которые стали пищей для нейросетей. Система использует информацию из открытых данных, чтобы определить, использовались ли ваши фотографии в исследованиях.

О такой дилемме мы рассказывали два года назад: IBM незаконно использовала миллионы фотографий людей с Flickr. Все фотографии были переданы по лицензии Creative Commons: их можно свободно использовать с некоторыми ограничениями. Однако даже самые разрешающие лицензии Creative Commons не допускают использования фотографий для обучения систем распознавания лиц по этническому признаку.

Теперь вы сможете проверить, кто использовал ваши фото. В Exposing.AI достаточно ввести имя пользователя Flickr, URL фотографии или хэштег, и инструмент просканирует более 3,5 миллионов фотографий в поиске ваших. Если он находит точное совпадение, результаты отображаются на экране.

При этом сам алгоритм поиска не использует ваше лицо – можно быть спокойным, что авторы не угонят информацию о вас.

Exposing.ai часть проекта MegaPixels, который исследует истории создания и использования наборов данных для обучения. Создатели инструмента заявили, что проект основан на многолетних исследованиях в области технологий:

«После отслеживания и анализа сотен наборов была выявлена закономерность: миллионы изображений загружались с Flickr.com, где лояльны к правам на контент и можно найти биометрические данные».

Быстрые результаты

Томас Макалэй из The Next Web протестировал инструмент на учетных записях Flickr, которые делятся фотографиями с публикой по лицензии Creative Commons. Уже второй аккаунт нашелся в базах нейросетей.

К сожалению, дальнейшие действия зависят от конкретного автора исследований или компании, которая использовала ваши фото. Некоторые позволяют запрашивать удаление из будущих выпусков наборов данных.

Exposing.AI также работает только на Flickr и не охватывает все наборы данных для обучения. Создатели говорят, что в будущих версиях они добавят возможности поиска.

На данный момент основная сила инструмента – показать, как наши фотографии используются для обучения алгоритмов без нашего согласия. Только изменения в законах могут предотвратить эту практику.

Читайте также:

Полезный гайд для 2020 года: как определить фэйковые фотографии несуществующих людей

Разработчики представили нейросеть, которая создаёт любые изображения по описанию